Wir wollen nicht mehr twittern!

Wie wir in Zukunft Texte schreiben (lassen) – ein Experiment mit der KI Generative Pre-Trained Transformer 3 (GPT-3), fachlich eingeordnet von Prof. Dr. Philipp Schaer, Professor für Information Retrieval und Direktor des Instituts für Informationsmanagement.

Technologie kommt oft dort zum Tragen, wo Menschen Prozesse automatisieren möchten, die in Eigenarbeit viel Zeit oder Energie kosten würden. Das gilt nicht nur in der Herstellung von Hämmern, Nägeln und Dampfmaschinen, sondern auch in der Produktion von Texten für Zeitungen, Blogs oder Social Media.

Menschliche Sprache ist aber komplex und folgt vielen expliziten und impliziten Regeln, die man nicht ohne Weiteres in einer Software zusammenfassen kann, die die Schreibarbeit übernimmt. Bei genau dieser Art von Aufgaben kann maschinelles Lernen eingesetzt werden, weil die Regeln, nach denen Sprache funktioniert, nicht mehr manuell programmiert werden müssen, sondern maschinell erlernt werden können.

(Bild: AdobeStock.com)

(Bild: AdobeStock.com)

Auf diese Weise ist auch das Sprachmodell GPT-3 (Generative Pre-Trained Transformer 3) des amerikanischen Unternehmens Open AI entstanden. Es kann zur automatischen Verarbeitung menschlicher Sprache verwendet werden und dabei unterschiedlichste Aufgaben lösen. Zum Beispiel kann das Modell die schriftliche Beschreibung eines einfachen Computerprogramms in den Code übersetzen, der das Programm ausführbar macht. Außerdem ist es möglich, Texte im Stil anderer Autorinnen und Autoren formulieren zu lassen. GPT-3 hat als ungewöhnlich leistungsstarkes Modell vor allem deshalb sehr viel Aufmerksamkeit bekommen, weil es mit enorm großen Datensätzen trainiert werden konnte.

Beim Training der KI wird Textmaterial in kleinere Blöcke, sogenannte Tokens, unterteilt. Diese Tokens sind Buchstabenfolgen, zum Beispiel Silben, die häufiger im Datensatz auftauchen. Durch das maschinelle Lernen wird versucht zu ermitteln, welcher Token am wahrscheinlichsten auf den letzten folgt. So könnte beispielsweise der Textbaustein „Kon“ existieren, auf den mit einer gewissen Wahrscheinlichkeit der Baustein „text“ folgt. Kontextabhängig wird die Wahrscheinlichkeit für die nächste Silbe oder das nächste Wort dann angepasst, um konfuse Satzstrukturen zu vermeiden.

Wir wollen uns selber ein Bild machen, wie gut die Software bereits funktioniert. Deshalb haben wir GPT-3 damit beauftragt, einen Tweet im Stil des Twitter-Accounts der TH Köln zu schreiben. Dazu haben wir die Tweets unseres Accounts @th_koeln in den sogenannten Playground von Open AI kopiert und die KI einen weiteren Tweet erzeugen lassen.

Welcher der beiden Tweets ist von einer Maschine geschrieben?

0 / 0

0 / 0

Schülerfirmen: Das Unternehmertum von Schülerinnen und Schülern wird an der TH Köln gefördert. Dafür steht seit kurzem eine neue Online-Plattform zur Verfügung. (Bild: TH Köln)

Warum zwitschert die KI so echt? – Eine fachliche Einordnung von Prof. Dr. Philipp Schaer

Prof. Schaer, wie gut finden Sie unsere GPT-3-Tweets?

Beide Tweets machen es einem wirklich schwer, denn sie wirken sehr natürlich und organisch. Frühere maschinelle Ansätze hatten oft grammatikalische Fehler, die Formulierungen waren gestanzt, alles war recht schablonenhaft. Mittlerweile fällt es zunehmend schwer, den berühmten Turing-Test auf solche Systeme anzuwenden, um zu untersuchen: Ist das ein Mensch oder eine Maschine? Insofern muss ich sagen: Beide Tweets sind glaubhaft.

Warum liefert GPT-3 so glaubwürdige Ergebnisse?

Die früheren Sprachmodelle waren rein statistische Auswertungen von wahrscheinlichen Wortfolgen. Sie basierten darauf, dass immer nur das nächste Wort vorausgesagt wurde, und zwar immer nur in einer bestimmten Wortfolge, ohne Kontextabhängigkeit und zudem immer nur in einer Richtung: von links nach rechts. Aber so funktioniert ja Sprache nicht. Wir beziehen uns in einem Satz auf eine Information aus einem vorangegangenen oder noch folgenden Satz. Deshalb sind Sprachmodelle wie GPT-3 mittlerweile kontextualisiert, d. h., sie erfassen und erkennen den Kontext. Dadurch können sie Wortbedeutungen erkennen: Ist mit „Bank“ das Finanzinstitut gemeint oder die Sitzgelegenheit?

Weitere Gründe für die überzeugenden Ergebnisse sind die riesigen, Terabytes großen Datenmengen, mit denen GPT-3 trainiert wurde, und zwar über alle möglichen Sprachen hinweg. Vor einigen Jahren gab es weder diese Masse an Daten, noch konnten sie in dieser Form verarbeitet werden. Der dritte, ebenso wichtige Punkt sind die sogenannten Transformer-Modelle. Letztlich handelt es sich hier um neue Algorithmen. Sie werden auf einem großen Webkorpus trainiert und anschließend auf genau den Anwendungsfall noch einmal feintrainiert, den man haben möchte: Als Chat-Bot für ein Onlineportal, um automatische Benutzeranleitungen zu schreiben, Tweets zu generieren oder zu programmieren. Für dieses Feintraining braucht die Anwendung lediglich Beispieldaten. Dafür reicht bereits eine relativ kleine Datenmenge aus. Im Falle der Tweets adaptiert GPT-3 dann die spezifische Wortwahl, Formulierungen und Phrasen unserer Hochschul-Tweets.

Informatiker Dr. Philipp Schaer ist seit 2016 Professor für Information Retrival an der Fakultät für Informations- und Kommunikationswissenschaften

(Bild: Thilo Schmülgen/TH Köln)

Informatiker Dr. Philipp Schaer ist seit 2016 Professor für Information Retrival an der Fakultät für Informations- und Kommunikationswissenschaften

(Bild: Thilo Schmülgen/TH Köln)

Wie lässt sich der Wildwuchs an Daten so bereinigen, dass man eine KI vernünftig trainieren kann? Das ist ein gigantisches Problem.”

Dr. Philipp Schaer ist Professor für Information Retrieval, Direktor des Instituts für Informationsmanagement und Mitglied im Promotionskolleg NRW.

Solche Anwendungsmöglichkeiten bergen doch unweigerlich auch Risiken?

Natürlich tun sie das. Wenn ich nicht mehr erkennen kann, dass ich mich mit einer Maschine unterhalte, hat das einen direkten Einfluss auf meine Entscheidungen. Da solche Systeme aber auch Chancen bieten, ist der entscheidende Punkt die Transparenz und die Kennzeichnungspflicht. Als Konsument und Kunde, beispielsweise bei meiner Onlinebank, würde es mich freuen, wenn mir signalisiert wird, dass gerade ein Chat-Bot mit mir Kontakt aufgenommen hat und keine menschliche Bankberaterin.

Und welche Probleme bergen Anwendungen wie GPT-3 im Hinblick auf die Datenmengen, mit denen sie trainiert werden?

Da gibt es gleich mehrere Probleme. Es gab vor einigen Jahren das Chat-Bot Tay von Microsoft. Es wurde unter anderem mit dem Onlineforum Reddit trainiert. Reddit ist dafür bekannt, alle abstrusen Themen dieser Welt aufzugreifen, Verschwörungstheorien, Holocaust-Leugnungen und was weiß ich nicht alles. Und auf all diese Daten wurde das System trainiert. Was dazu führte, dass das Chat-Bot in kürzester Zeit regelrecht Amok gelaufen ist, zum Holocaust-Leugner wurde und seine Themen fröhlich in die Welt posaunte. So dass sich Microsoft genötigt sah, Tay über Nacht den Stecker zu ziehen. Sprachlich waren die Tweets durchaus elaboriert, doch sie überstiegen jegliche Grenze des Anstands. Aber letztlich hatte das Bot nur wiedergegeben, was es gelernt hatte. Dieser Wildwuchs an Daten ist ein gigantisches Problem: Wie lässt sich dieser Dateninput so bereinigen, dass man eine KI vernünftig trainieren kann? Da droht das nächste Problem, und das heißt Zensur.

Gibt es auch andere Möglichkeiten statt der Zensur?

Es gibt durchaus die Möglichkeit der Bias-Detektion. Das heißt, man schaut, ob Verzerrungen vorliegen: sei es eine Überrepräsentation bestimmter Themen oder eine Unterrepräsentation eines Geschlechts. Das setzt aber immer voraus, dass diese Daten halbwegs quantifizierbar sind. Doch das ist in vielen Bereichen einfacher gesagt als getan. Wir forschen im zu gründenden Forschungsschwerpunkt Knowledge Discovery ebenfalls in diesem Bereich, konkret zur Suchvervollständigung von Suchmaschinen. Hier handelt es sich um den gleichen Ansatzpunkt: Das System schlägt mir eine Suchvervollständigung vor, aber warum? Wir konnten unter anderem eine Gender-Bias belegen: Suchvervollständigungen für Frauen sind andere als für Männer. Wenn also in den vorhandenen Daten, mit denen das System lernt, ein Gender-Bias steckt, wird das System diesen auch 1:1 abrufen. Also müssen wir entweder eine Bias-Detektion entwickeln, oder wir lassen die Systeme wertfrei lernen und sorgen anschließend bei der Ausgabe für die Qualitätskontrolle.

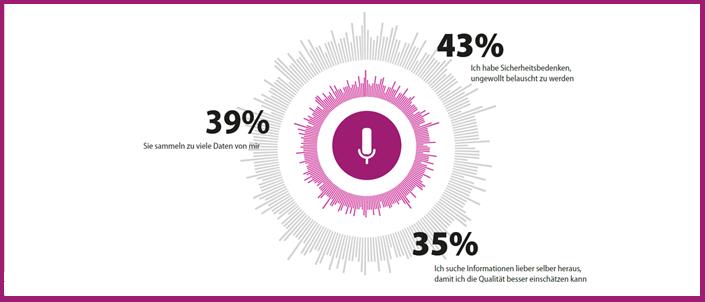

Quelle: EARSandEYES 2018, Statista.de. In der Umfrage wurden 1.008 Bürgerinnen und Bürger in Deutschland zu den Gründen gegen die Nutzung von Sprachassistenten befragt.

(Bild: Anna Wöffen / TH Köln)

Quelle: EARSandEYES 2018, Statista.de. In der Umfrage wurden 1.008 Bürgerinnen und Bürger in Deutschland zu den Gründen gegen die Nutzung von Sprachassistenten befragt.

(Bild: Anna Wöffen / TH Köln)

Kann GPT-3 auch im Journalismus eingesetzt werden?

Tools wie GPT-3 kommen bereits zur Anwendung und könnten auch gut im Journalismus eingesetzt werden. Zum Beispiel im Sportjournalismus, d. h. bei Berichterstattungen, die auf relativ strukturierte Art und Weise erfolgen: Auf Grundlage der Spieldaten kann bereits Text für einen Beitrag oder für einen Liveticker generiert werden, der vom Fachjournalisten lediglich geprüft und angepasst werden muss. Das sind bereits reale Szenarien. Ein anderes sind Betriebsanleitungen, die einmal strukturiert formuliert sind und vom System gut verständlich in beliebig viele Sprachen übersetzt werden. Insofern können die Systeme bereits viel Nützliches übernehmen. Mir persönlich ist allerdings wohler, wenn am Ende der Kette ein Mensch die Qualitätskontrolle übernimmt.

Kann GPT-3 auch im Bereich Information Retrieval eingesetzt werden?

Nein, da ist GPT-3 unpraktisch. Denn beim Information Retrieval geht es darum, Sprache zu verstehen statt zu generieren. Hier gibt es aber einen anderen Ansatz, der ebenfalls auf der Transformer-Technik basiert, und zwar BERT. Dieses System geht gerade regelrecht durch die Decke, da es in der Lage ist, die Kontextinformationen und damit Mehrdeutigkeiten aus Texten herauszulesen. Dahinter steckt der sogenannte Attention-Mechanismus, der das System sehr sensibel macht für diese Kontextinformationen. Tatsächlich stammt BERT aus der Feder von Google, ist aber mittlerweile frei zugänglich für Forschergruppen und andere Anwendungsfelder. Durch den Einsatz dieser Transformer-Modelle und des Attention-Mechanismus erreicht man mittlerweile bei der maschinellen Texterkennung eine Verbesserung von 20 bis 30 Prozent. Das ist enorm.

Was ist für Sie The Next Big Thing?

Natürlich liegt der Fokus derzeit auf „höher, schneller, weiter“. Aber irgendwann wird diese Steigerungsrate ausgeschöpft sein. Weil man beispielsweise nicht noch mehr Daten generieren kann oder weil ein Mehr an Daten nicht zu noch besseren Ergebnissen führen wird. In diesem Fall spricht man von einem Overfitting: Das Modell bildet durch ein Zuviel an Daten nicht mehr die Realität ab. The Next Big Thing wird die Explainable AI sein, also die nachvollziehbare KI: Was hat das System bewogen, den Text so zu formulieren? Warum hat das System den Text so und nicht anders verstanden? Warum ist meine Suchanfrage jetzt so interpretiert worden und ich erhalte diese Ergebnisse? Also quasi eine Transparenz des Systems und eine Nachvollziehbarkeit für den Menschen.

September 2022