Mehr Datenschutz durch Lernen im Verbund

Qualität und Güte von Algorithmen der Künstlichen Intelligenz (KI) sind untrennbar mit der verfügbaren Datenmenge verbunden. Für viele Unternehmen und Einrichtungen ist das ein Problem: Vorhandene Daten unterliegen häufig dem Datenschutz, der erfolgreiche Einsatz von KI bleibt deshalb auf der Strecke.

Prof. Dr. Daniel Gaida vom Institut für Informatik spricht im Interview über das so genannte Federated Learning – eine Möglichkeit, KI auch unter Wahrung des Datenschutzes einzusetzen.

Prof. Gaida, welchen Mehrwert bietet KI überhaupt für Unternehmen und Einrichtungen?

Künstliche Intelligenz kann in vielen Bereichen unterstützend wirken und Prozesse optimieren. Ein Beispiel dafür sind Routinetätigkeiten in der Produktion wie die Überprüfung von Einzelteilen auf einem Fließband. Diese kann von einer KI übernommen werden, indem sie ein Kamerabild überwacht, analysiert und daraufhin entscheidet, ob ein Objekt in Ordnung ist oder eben nicht. Ein anderes sehr aktuelles Beispiel ist der Gesundheitsbereich: Hier kann künstliche Intelligenz eingesetzt werden, um Daten von Patientinnen und Patienten auszulesen. Ärztinnen und Ärzte müssen sich so nicht mehr sämtliche Informationen anschauen, sondern können ganz gezielt die von der KI vorausgewählten Daten begutachten.

(Bild: privat)

(Bild: privat)

Die Souveränität über die eigenen Daten bleibt bestehen und der Datenfluss wird transparenter gehalten.”

Prof. Dr. Daniel Gaida lehrt und forscht zu cyberphysischen Systemen an der Fakultät für Informatik und Ingenieurwissenschaften am Campus Gummersbach der TH Köln.

Wie funktionieren solche Anwendungen?

Ganz grundsätzlich basieren solche Prozesse auf dem Prinzip des maschinellen Lernens. Dabei lernt das künstliche System aus Beispielen und kann diese verallgemeinern beziehungsweise Muster und Gesetzmäßigkeiten daraus ablei- ten. Um möglichst präzise Ergebnisse zu erzielen, ist ein umfassendes Training notwendig. Bei KI-basierten medizinischen Werkzeugen – zum Beispiel Tumordetektoren – muss die künstliche Intelligenz etwa mit Bildern der Tumore gespeist werden. Zusätzlich müssen Medizinerinnen und Mediziner jeden Tumor beispielsweise durch histologische Untersuchungen klassifizieren, damit die KI aus diesen Daten lernen und Tumore effizienter erkennen kann. Es wird demnach eine extrem große Menge an Datensätzen benötigt, um das Gesamtsystem zu optimieren.

Und hier kommt der Datenschutz ins Spiel ...

Richtig. Künstliche Intelligenz benötigt Informationen aus Einrichtungen, Unternehmen oder von Nutzerinnen oder Nutzern – also persönliche oder sensible Daten, die besonders schützenswert sind. Häufig ist es nämlich so, dass sensible Daten wie beispielsweise Maschinen- oder Produktionsdaten oder persönliche Informationen wie etwa Kurznachrichten, Sprachaufzeichnungen oder Bilder, besonders interessant für das Training von KI-Modellen sind. Hier kommen dann allerdings die informationelle Selbstbestimmung und der Schutz der Persönlichkeitsrechte ins Spiel. Diese Aspekte und die damit einhergehenden daten- schutzrechtlichen Hürden sorgen dafür, dass viele Unternehmen und Einrichtungen entweder nur schwer an geeignete Datensätze gelangen, oder aber den Einsatz von künstlicher Intelligenz gänzlich scheuen.

Wie kann der Ansatz des Federated Learnings hier Abhilfe schaffen?

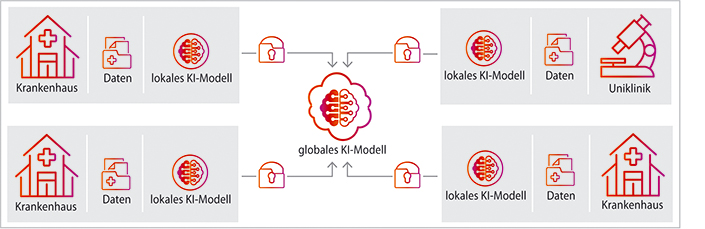

Wenn wir mal beim Beispiel der Tumordetektoren bleiben: Hier werden also zahlreiche persönliche und sensible Informationen von Krankheitsbildern und -verläufen aus Einrichtungen sowie von Patientinnen und Patienten benötigt, um eine gute KI zu entwickeln und zu optimieren. Dafür reichen die Datensätze einzelner Krankenhäuser oder Labore allerdings nicht aus. Das heißt, sie müssen gemeinsam im Verbund ein KI-Modell trainieren, um gute Resultate zu erzielen. Ein mögliches Vorgehen wäre nun, alle Daten an einem zentralen Ort zusammenzuführen und auf dieser Basis ein KI-Modell zu trainieren – hier gelangen wir aber an datenschutzrechtliche Grenzen. Das liegt daran, dass eigene Datensätze mit Externen ausgetauscht werden und damit potenziell Unbefugte Zugriff auf diese Daten bekommen könnten. An dieser Stelle setzt nun das Federated Learning an: Anstatt die Daten zum Modell zu bringen, wird das Modell zu den Daten gebracht. Das bedeutet, dass die KI über dezentrale Server in den einzelnen Einrichtungen trainiert wird. Dort kommen lediglich lokale Datensätze zum Einsatz. Es entstehen zunächst also mehrere dezentrale KI- Modelle, aus denen die personenbezogenen Trainingsdaten nicht rekonstruiert werden können. In einem weiteren Schritt werden diese KI-Modelle schließlich zusammengeführt beziehungsweise ausgetauscht, bis ein qualitativ hochwertiges Modell entstanden ist.

Federated-Learning-Modell am Beispiel Krankenhäuser

(Bild: Monika Probst/TH Köln)

Federated-Learning-Modell am Beispiel Krankenhäuser

(Bild: Monika Probst/TH Köln)

Und so werden die Daten besser geschützt?

Ganz genau. Jede für Datenschutz verantwortliche Person in den beteiligten Einrichtungen kann eigene Prozesse und Datenschutzrichtlinien definieren, den Datenzugriff kontrollieren und hat die Möglichkeit, diesen zu widerrufen. Die Souveränität über die Daten bleibt somit bestehen und der Datenfluss wird transparenter gehalten. Die mit den ausgetauschten einzelnen Modellen übermittelten Parameter können ohne Weiteres verschlüsselt werden, so dass die Daten auch immer im eigenen Haus verbleiben.

Welche Möglichkeiten entstehen dadurch?

Durch den kollaborativen Ansatz des Federated Learnings können bisher ungenutzte Potenziale erschlossen werden. Ein einzelnes Krankenhaus zum Beispiel wäre mit den wenigen vorhandenen Datensätzen nicht in der Lage, ein qualitativ hochwertiges KI-Modell zur Tumordetektion zu entwickeln. Durch den datenschutzkonformen Austausch und den gemeinsamen Trainingsprozess kann eine künstliche Intelligenz entwickelt werden, die bessere Entscheidungen trifft. Das macht den Prozess grundsätzlich auch kostengünstiger.

Und welche Herausforderungen gibt es noch?

Das Federated Learning ist noch eine recht neue Methode, das heißt, es gibt noch ein paar Baustellen. Der Kommunikationsaufwand zwischen den einzelnen Unternehmen und Einrichtungen ist relativ hoch. Hinzu kommt, dass alle Beteiligten ihr eigenes System und ihre eigenen Datenbanken besitzen. Es gibt demnach vielfältige Datensätze aus mehreren Quellen, die integriert und in ein einheitliches KI-Modell übersetzt werden müssen – das ist schwierig und erfordert eine gute Systemarchitektur. Diese muss natürlich auch die Verschlüsselung von Informationen und die unterschiedlichen Rechenressourcen berücksichtigen. Das erfordert alles in allem einiges an Entwicklungs- und Optimierungsarbeit.

September 2022