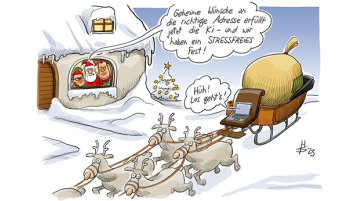

2024 bringt die KI-Verordnung

Nach einem Verhandlungsmarathon von fast drei Tagen Anfang Dezember 2023 scheint die Zukunft der KI-Verordnung gesichert. Die Vertreter der Mitgliedstaaten der EU, die Kommission und das Europaparlament haben zäh gerungen und wollen, dass Europa ein starkes und gutes Signal für eine vertrauenswürdige KI in die Welt sendet.

19.12.2023

Prof. Dr. Rolf Schwartmann, Leiter der Kölner Forschungsstelle für Medienrecht an der TH Köln

2024 bringt die KI-Verordnung

Nach einem Verhandlungsmarathon von fast drei Tagen Anfang Dezember 2023 scheint die Zukunft der KI-Verordnung gesichert. Die Vertreter der Mitgliedstaaten der EU, die Kommission und das Europaparlament haben zäh gerungen und wollen, dass Europa ein starkes und gutes Signal für eine vertrauenswürdige KI in die Welt sendet.

Im Detail ist noch vieles streitig.1 Im Grundsatz soll es einen risikoorientierten Ansatz geben, der gestufte Regeln abhängig vom Risiko vorsieht, das von einer KI ausgeht. Anwendungen mit minimalem Risiko, die etwa Produkte zum Kauf empfehlen, sollen von strengen und speziellen Verpflichtungen befreit sein.

Hohes Risiko verlangt strenge Regeln

Risikoreiche Anwendungen, die in der Verordnung so präzise wie möglich benannt werden, müssen strenge und spezifische Verpflichtungen erfüllen. Das gilt etwa für KI-Systeme, die Einfluss auf den Zugang zu Bildungseinrichtungen haben, oder für solche, die in der Medizin oder in der Rechtspflege eingesetzt werden. Sie müssen nachweislich robust und störungsfrei laufen und ihre Betreiber müssen deren Aktivitäten transparent machen sowie protokollieren und sie müssen Sicherheit gegenüber Hackerangriffen aufweisen.

Inakzeptable Anwendungen sind verboten

Manche Systeme sind auch ganz verboten, weil sie ein nicht akzeptables Risiko aufweisen. Das gilt etwa für Sprachsysteme, die Menschen manipulieren oder gar Kinder negativ beeinflussen können oder für Anwendungen, die Staaten einsetzen können, um Bürger zu bewerten.

Zeitplan der KI-Verordnung

Die geplanten regulativen Leitlinien sind jedenfalls im Grundsatz zu begrüßen. Ihre Wirksamkeit wird von der konkreten Ausgestaltung der Regulierung abhängen, welche die Mitarbeiter des Parlaments in den kommenden Wochen und Monaten in den technischen Gesprächen erarbeiten müssen. Läuft alles nach Plan, soll der Gesetzestext bis Anfang Februar 2024 stehen und die KI-Verordnung noch vor der Europawahl im Juni 2024 verabschiedet werden.

Sprachmodelle wissen nichts

Ein Problem ist besonders relevant. Unabhängig von ihrem konkreten Einsatzzweck fußt die mächtige Technik, die autonom Sprache und Bilder erzeugt, auf enorm großen Datenpools. Aus ihnen beziehen Systeme, die KI-basiert Texte generieren, ihr „Wissen“. Diese Datenpools bezeichnet der Entwurf der KI-Verordnung als General Purpose KI (GPAI). Damit ist gemeint, dass diese Datenpools nicht darauf spezialisiert sind bestimmte Aussagen hervorzubringen oder zu bestimmten Zwecken eingesetzt zu werden. Diesen sog. Basismodellen wurde über das „Füttern“ mit Daten eine allgemeine Sprachverarbeitungskompetenz antrainiert.

Computer rechnen nur

Ihre eigentliche Spezialität ist nicht, dass sie Wissen enthalten, sondern, dass sie aus Wissensdatenbanken mit Mitteln der Wahrscheinlichkeitsrechnung sinnvolle und zusammenhängende Texte hervorbringen. Sie arbeiten sog. Prompts, also Anfragen, ab. Je spezifischer die Frage ist, desto präziser ist die Antwort. Aus der Datenbasis wird keine Antwort auf eine Frage generiert, mit der etwas Unrechtes zum Ausdruck gebracht werden soll.

Vernunft ist keine Kategorie der Maschine

Allerdings bergen diese Datenmodelle ein besonders Risiko. Sie liefern zwar Texte, die sich für den menschlichen Nutzer als sinnvolle und zusammenhängende Aussage darstellen. Das System produziert diese Texte allerdings nicht in einem Sinnzusammenhang, sondern Wort für Wort auf der Basis von Wahrscheinlichkeiten. Antworten von Robotern auf menschliche Fragen sind nur eine mathematisch errechnete Simulation menschlicher Gedanken, ohne eigene Vernunft.

Maschinen lassen sich provozieren

Menschen können die Schwachstellen dieser Technologie bewusst ausnutzen: Provoziert man das KI-System nämlich durch einen Prompt dazu, fragwürdige Ergebnisse zu liefern, dann wird es diese aufgrund der mathematischen Gesetze der Wahrscheinlichkeitsrechnung auch liefern. So wird das KI-System bei Eingabe eines entsprechenden Prompts den Satz „Das Schöne an der Diskriminierung von Schwachen ist, …“ sprachlich sinnvoll, aber rechtlich und moralisch inakzeptabel vervollständigen.

Gehören alle Fakten und Meinungen in die Daten?

Will man derartige Ergebnisse verhindern, muss man den Sprachmodellen solche Antworten abtrainieren. Das wiederum birgt große Probleme, denn dazu muss man entscheiden, welches missliebige, aber historisch korrekte Faktum man aus der Datenbasis ausnimmt und wo die Grenze zwischen verbotener und erlaubter Meinungsäußerung verläuft. Unabhängig davon sind KI-Systeme bislang weit davon entfernt, die komplexen rechtlichen Abwägungen etwa im Bereich des Persönlichkeitsrechts vornehmen, also mathematisch simulieren zu können. Es darf auch bezweifelt werden, dass solche Abwägungen in der demokratischen Gesellschaft jemals von einer KI übernommen werden sollten.

Große Herausforderung für die Nutzenden

Im Rahmen der nun vereinbarten Regulierung wurde darauf verzichtet, Hersteller von GPAI gesetzlich dazu zu verpflichten, KI-Anwendungen so zu trainieren, dass bei deren Einsatz keine Rechtsverletzungen auftreten. Jedenfalls solange eine Zuweisung der Verantwortlichkeiten entlang der KI-Wertschöpfungskette noch nicht feststeht, sind wir als einzelne Nutzer dazu berufen, die Ergebnisse unserer Prompts kritisch zu hinterfragen und auf etwaige Rechtsverletzungen zu überprüfen. Die vermeintlich allwissende Technik zu überprüfen, droht zu einer übermenschlichen Aufgabe zu werden. Spätestens diese Verantwortung können wir nicht delegieren.

Dezember 2023